编者话:首先恭喜豪迈成为社区版本发布提名的第一个“杰出贡献者” ,其次从我们中国社区的角度来说,我觉得这是一个向世界展现中国开源力量的一个体现。如 OpenStack 项目一样,前段时间的独立董事选举、OpenStack 代码贡献度等等事件,在 OpenStack 项目里中国的企业正在一步步的向世界证明中国的开源力量。同时 Ceph 中国社区在今年也会计划筹办 Ceph Hackathon 活动,让更多的 Ceph 中国企业走向世界,向世界展示中国的开源力量。

下面来看看豪迈的简介:

原文译:

XSKY 使用 Ceph 的情况

XSKY 目前在其存储产品中使用 Ceph,提供用户友好的管理控制和操作。同时也向社区贡献了很多性能优化方面的代码:SPDK、DPDK、RDMA 等。

Ceph 未来计划

豪迈和 XSKY 在未来都希望把 Ceph 完善的更好,来帮助更多的用户。

关于豪迈个人

豪迈是一个非常活泼的人。他个人的代码开发环境是运行在 MAC 系统中的 VirtualBox。在 Ceph 之前,豪迈对 VirtualBox 挺感兴趣,并为此项目贡献了代码。同时豪迈也是一个游戏达人,从 War3 玩到 WoW,玩了很多年。

CEPH 简介

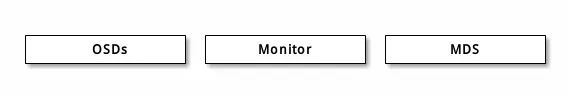

不管你是想为云平台提供 Ceph 对象存储和/或 Ceph 块设备,还是想部署一个 Ceph 文件系统或者把 Ceph 作为他用,所有 Ceph 存储集群的部署都始于部署一个个 Ceph 节点、网络和 Ceph 存储集群。 Ceph 存储集群至少需要一个 Ceph Monitor 和两个 OSD 守护进程。而运行 Ceph 文件系统客户端时,则必须要有元数据服务器( Metadata Server )。

Ceph OSDs: Ceph OSD 守护进程( Ceph OSD )的功能是存储数据,处理数据的复制、恢复、回填、再均衡,并通过检查其他 OSD 守护进程的心跳来向 Ceph Monitors 提供一些监控信息。当 Ceph 存储集群设定为有 2 个副本时,至少需要 2 个 OSD 守护进程,集群才能达到 active clean 状态( Ceph 默认有 3 个副本,但你可以调整副本数)。

Monitors: Ceph Monitor 维护着展示集群状态的各种图表,包括监视器图、 OSD 图、归置组( PG )图、和 CRUSH 图。 Ceph 保存着发生在 Monitors 、 OSD 和 PG 上的每一次状态变更的历史信息(称为 epoch )。

MDSs: Ceph 元数据服务器( MDS )为 Ceph 文件系统存储元数据(也就是说,Ceph 块设备和 Ceph 对象存储不使用 MDS )。元数据服务器使得 POSIX 文件系统的用户们,可以在不对 Ceph 存储集群造成负担的前提下,执行诸如 ls、find 等基本命令。

Ceph 把客户端数据保存为存储池内的对象。通过使用 CRUSH 算法, Ceph 可以计算出哪个归置组(PG)应该持有指定的对象(Object),然后进一步计算出哪个 OSD 守护进程持有该归置组。 CRUSH 算法使得 Ceph 存储集群能够动态地伸缩、再均衡和修复。