当无人驾驶汽车遇到无法避免的交通事故时,无人驾驶汽车应该怎样应对呢?(是保护车主还是冲向路人?)现在,麻省理工学院(MIT)的研究人员希望你在“道德机器”中回答这个问题。这个简单的网站就像有名的电车难题(The Trolley Problem)。

根据维基百科的解释, 电车难题的大致内容是:一个疯子把五个无辜的人绑在电车轨道上。一辆失控的电车朝他们驶来,并且片刻后就要碾压到他们。不过你可以拉一个拉杆,让电车开到另一条轨道上。然而问题在于,疯子在另一个电车轨道上也绑了一个人。考虑以上状况,你是否应拉杆?你面临着两种选择:一是什么都不做, 这样电车将会碾压到主轨道上的五个人。 第二种选择是拉起拉杆,让电车开到另一条轨道上。这样另一条轨道上的那个人就会死亡。

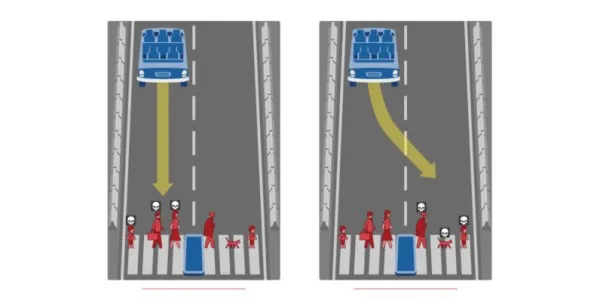

现在,MIT的“道德机器”让你能像程序员一样“训练”一辆无人驾驶汽车来处理这些不常见的情况。 在模拟中, 你会遇到一些有趣的情景。 人类的生命比动物的生命更有价值吗?你会保护路上的两个罪犯和两个无辜的人,还是保护司机和三个乘客(所有都是无辜的)?年轻人的生命比老年人的生命更有价值吗?女性生命的价值超过男性吗?这些都没有正确的答案,但其在决定人类认为无人驾驶汽车应该如何应对事故中的伦理困境时有一定作用。