不同于 AlphaGo 所处的“完美环境”,在复杂和不完美的环境中,智能体能高效地思考,对未来的结果进行想象吗?DeepMind 推出新论文,描述了一类基于想象来进行计划的新方法,在不完美的环境中也同样具有高效性。

雷锋网 AI 科技评论将其编译如下:

在行动之前想象可能出现的结果是人类认知中的一个有力工具。例如,当在桌子边缘放一个玻璃杯,我们会停下来想一想:这样稳固吗,杯子会不会掉下来。根据想象的结果,我们会把杯子的位置调一下,防止它掉下来摔碎。这种慎重的推理过程实际上就是想象,它是人类一种独特的能力,在日常生活中至关重要。

如果想让算法也能执行同样复杂的行为,那么这种算法也必须和人一样,对未来具有想象和推理能力。除此之外,他们还必须会利用这种能力来制定计划。已经有算法能做出许多引人瞩目的事情——特别是像 AlphaGo 这样的程序,它使用内部模型来分析行为是如何产生结果的,以便进行推理和计划。这些内部模型运行得很好,因为像围棋这样的环境是“完美的”——这些算法有明确定义的规则,在几乎所有情况下都能准确地预测出结果。但现实世界是复杂的,规则并不会定义得那么清楚,经常会有未知的情况出现。即使是最聪明的智能体,在这样的复杂环境中进行想象也是一个漫长、耗费巨大的过程。

能够应付不完美的环境,学会使规划策略适应当前的情况,这些都是重要的研究课题。

在论文 Learning model-based planning from scratch、Imagination-Augmented Agents for Deep Reinforcement Learning 中,DeepMind 描述了一类基于想象来进行计划的新方法。同时也介绍了一些架构,这种架构能为智能体提供学习和制定计划的新方法,使任务的效率最大化。这些架构很高效,在复杂和不完美的环境中具有鲁棒性,能够通过想象采取灵活的策略。

增强想象智能体

这类智能体得益于一个“想象力编码器”——能为智能体的未来决策提取一切有用信息,忽视无关信息的神经网络。这些智能体的明显特征如下:

能够学会说明智能体的内部模拟过程。这使得他们能够使用模型,粗略地捕捉环境的动态,即使有时候那些动态并不完美。

有效的运用想象力。通过改变想象的轨迹的数量,来适应问题。编码器也提高了效率,它能通过想象提取奖励之外的信息,这些想象的轨迹可能包含有用的线索,即使他们并不一定导致较高的奖励。

能学习不同的策略来制定计划。可以选择继续当前想象的轨迹或者从头开始。或者,他们可以利用不同的想象模型,这些模型具有不同的精度和计算成本。这为他们提供了大量高效的规划策略,而不是局限于一成不变的、在不完美环境中会限制系统适应性的方法。

测试架构

DeepMind 在不同的游戏上测试了这个架构,包括益智游戏推箱子和宇宙飞船航行游戏。这两款游戏都需要提前计划和推理,这使得它们成为测试智能体能力的绝佳环境。

在推箱子中,智能体必须把箱子推到目标上。因为箱子只能被推,许多移动都是不可逆的(例如,推到角落里的盒子不能被拉出来)。

在宇宙飞船游戏中,智能体必须通过固定的次数激活推进器,进而稳定飞船。在游戏中必须与几个星球的引力相抗衡,这是一个很复杂的非线性连续调节任务。

为了限制这两个游戏的试错行为,每一关都是程序生成的,失败之后不能再重玩。这鼓励智能体在实际环境中行动之前,先想象执行不同的策略带来的结果。

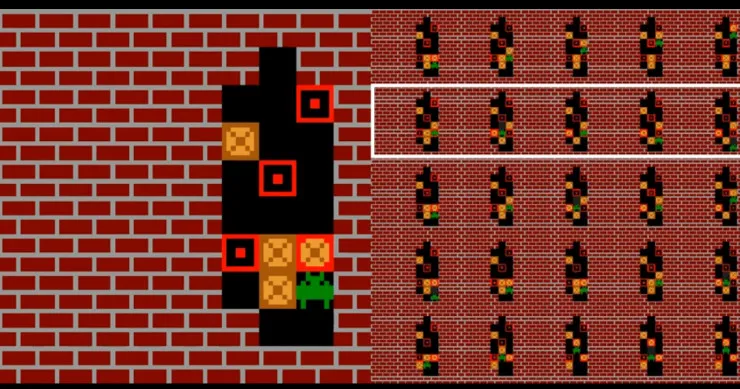

在上图中,游戏中的元素是以像素形式呈现给智能体的,它并不知道游戏的规则。在特定的时间点上,DeepMind 将智能体对接下来 5 种可能的想象进行了可视化。根据这些信息,智能体决定采取什么行动。相应的轨迹在图中已经标明。

图示为玩飞船游戏的智能体。红线表示在游戏中执行的轨迹操作,蓝线和绿线描述了想象的轨迹。

对于这两种任务,增强想象的智能体都优于作为基准的无想象智能体:他们可以通过更少的经验来学习,并且能够处理对环境建模时的缺陷。智能体能够从内部模拟中提取更多的知识,因此他们可以用更少的想象步骤解决更多的任务,优于传统的搜索方法,比如蒙特卡罗树搜索。

当增加一个有助于制定计划的管理组件时,智能体就会学着用更少的步骤更高效地解决问题。在宇宙飞船任务中,它可以分辨环境中的引力是强还是弱,这意味着需要不同数量的想象步骤。当为智能体提供环境中的多个模型时,每个模型在质量和成本上都有所不同,它学会了做出有意义的权衡。最后,如果每执行一步,想象的计算成本增加,那么智能体就会在早期想象多个步骤的结果,并且在之后依靠这种想象的结果,而不需要再次进行想象。

能够应付不完美的环境,并学会使规划策略适应当前的情况是重要的研究课题。DeepMind 的两篇新论文 Learning model-based planning from scratch、Imagination-Augmented Agents for Deep Reinforcement Learning,以及 Hamrick 等人之前的研究,考虑到了这些问题。基于模型的强化学习和计划是研究的热点,为了提供可扩展的方法来丰富基于模型的、能运用想象力对未来进行计划和推理的智能体,需要进一步分析和思考。

via:DeepMind Blog