arXiv.org 是一个专门收集物理学、数学、计算机科学与生物学论文预印本的网站。数据显示,截至 2014 年底的时候,arXiv 已经达到了一百万篇以上的论文藏量,并且还在以每月 8000 篇的速率增长。算是目前全球最具规模的论文数据库之一。

近日,来自斯坦福大学计算机学院的博士毕业生、OpenAI 的高级科学家 Andrej Karpathy 基于一份 arXiv 机器学习论文大数据,从论文数量、开源框架、数学模型和优化算法等多个方面对过去五年中的机器学习变化趋势进行了详细分析,并将分析结果发布在个人博客上。以下内容整理自该博客,雷锋网编译。

想必你一定听说过谷歌趋势(Google Trends)或者百度指数这种工具,任意输入一个关键词,就能立刻看到关于该词在过去几个月甚至几年之内的变化趋势。受此启发,碰巧我手边正好有一份 arXiv 论文数据集,它收集了过去五年中机器学习相关的 28303 篇论文。那么与谷歌趋势类似,从这些论文中,我们能否看到一些机器学习领域的科研发展趋势呢?我就此进行了详细的数据分析,发现这个结果相当有趣,因此在这里把它分享出来。

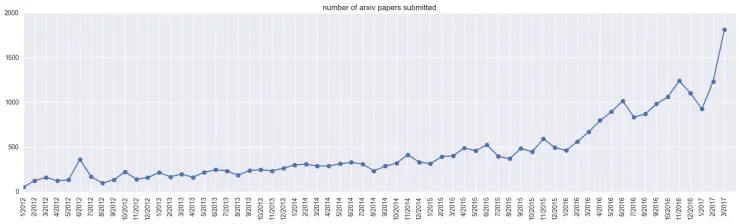

论文总量

首先我们看一下论文数量。在过去五年中,arXiv 收集的机器学习论文数量变化情况如下图所示。

从上图可以看到,论文总数在 2017 年 3 月出现了一次激增,从时间上看可能是由于 NIPS 和 ICML 等大型会议的论文提交截止日期正好在 3 月。而且有一点需要说明的是,arXiv 的论文数据集虽然全面,但也并不能完全代表整个机器学习行业的变化趋势,因为毕竟不是所有人都习惯于将自己的论文投递到 arXiv 网站上。不过,从上图我们仍然可以看到一个明显的上升趋势,这说明机器学习的热度的确在持续地上升中。

下面我们将以这些论文作为研究材料,看看其中包含着怎样的变化趋势。

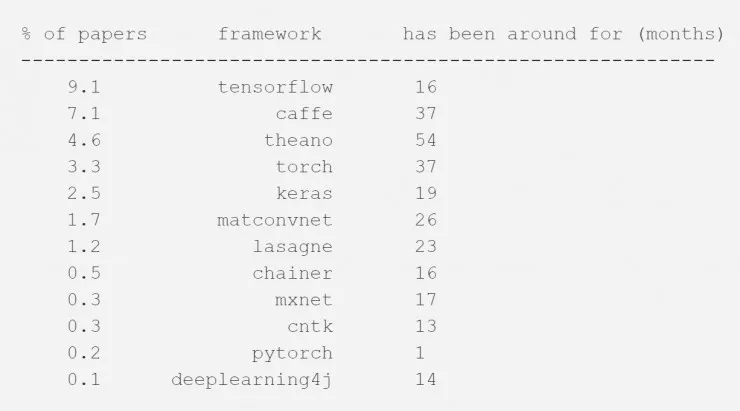

深度学习框架

首先看看深度学习框架的情况。这里我记录了在 2017 年 3 月上传的所有论文中(包括参考书目和论文内容)提到的机器学习框架情况:

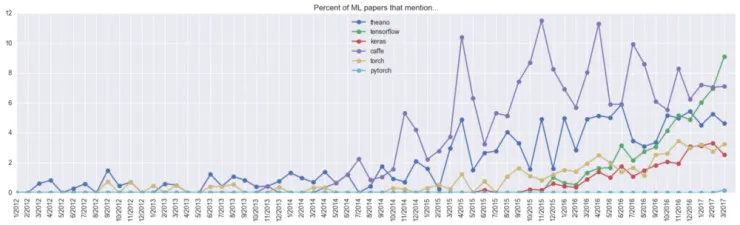

可以看到,在 2017 年 3 月份提交的所有论文中大约有 10% 都提到了 TensorFlow。当然,并不是每一篇论文都声明了框架的使用,但是如果我们假设论文以某一固定的概率分布来声明框架,并且这个概率与框架本身无关的话,那么大概有高达 40% 的社区都在使用 TensorFlow(如果也算上用 TensorFlow 作为 Keras 后端的论文,这一比例将会更大)。下面是这些框架随时间变化的趋势:

可以看到,Theano 已经高速发展了一段时间了,但近期它的增速正在放缓。Caffe 从 2014 年前后开始快速爆发,但在过去几个月中已经被强大的 TensorFlow 反超。Torch(以及最近的 PyTorch)也处于上升期,虽然增速略显缓慢,不过增长稳定。我估计再过几个月再来看这个结果会更有趣,因为根据我的估计,未来 Caffe 和 Theano 将会缓慢衰落,而由于 PyTorch 的崛起,TensorFlow 的增速可能会放缓。

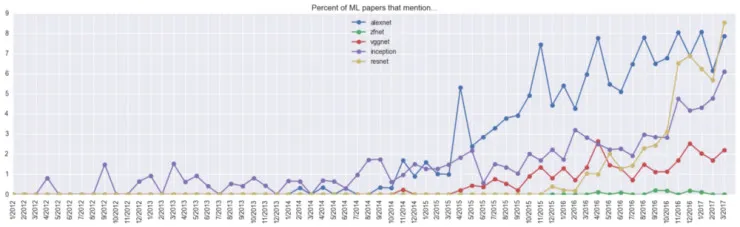

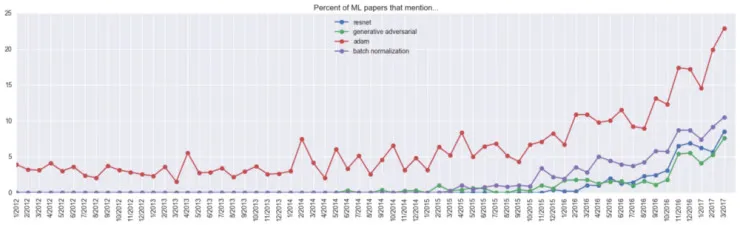

卷积神经网络模型(CNN)

下面再看一下卷积神经网络的情况,从下面的图表中可以清楚地看到,作为 CNN 领域里重要里程碑的 ResNets(深度残差网络)在 2016 年底的激增情况,在 2017 年 3 月提交的所有论文中甚至有大约 9% 都提到了 ResNets。

另外,这里还能看到在谷歌 InceptionNet 之前,实际上已经有论文提到了 inception 的概念。

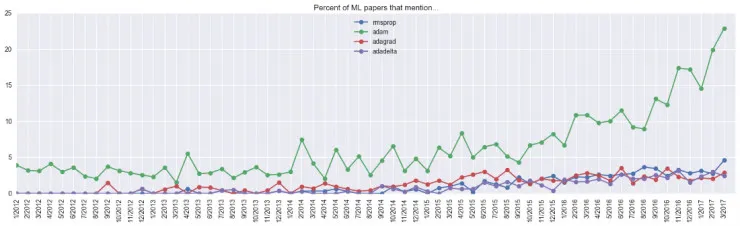

优化算法

在优化算法方面,Adam 算法可以算是应用最多的一个,大约有高达 23% 的论文都提到了它。这里需要说明的是,在实际使用中 Adam 算法的采用率可能更高,因为许多论文都不会显式地声明优化算法,更有一部分论文甚至不会阐述关于神经网络优化的内容。另外,从图表中还能看出,在 2014 年 12 月 Adam 优化算法被正式提出之前,实际上也有一些论文提到了 “Adam” 关键词,它的概率大约维持在 5% 左右,我猜想可能是因为有许多作者的名字也叫 Adam 的缘故。

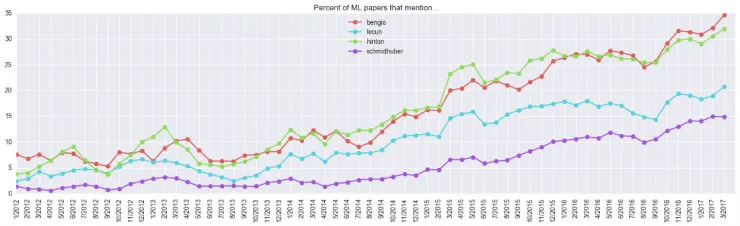

研究者

这里我还很好奇地研究了一下深度学习领域各位大牛的名字在论文中的变化情况,结果如下图所示。需要说明的是,这里的仅根据关键词统计的方式很粗糙,另外我还做了一些归一化操作。

从图表中可以看到,在所有提交的论文中,大约有 35% 提到了 bengio,但这里实际上有两个人: Samy 和 Yoshua,图中是两人加起来的结果。另外需要特别指出的是,在所有新论文中有超过 30% 都提到了 Geoff Hinton 大神,这一点很强大。

关键词

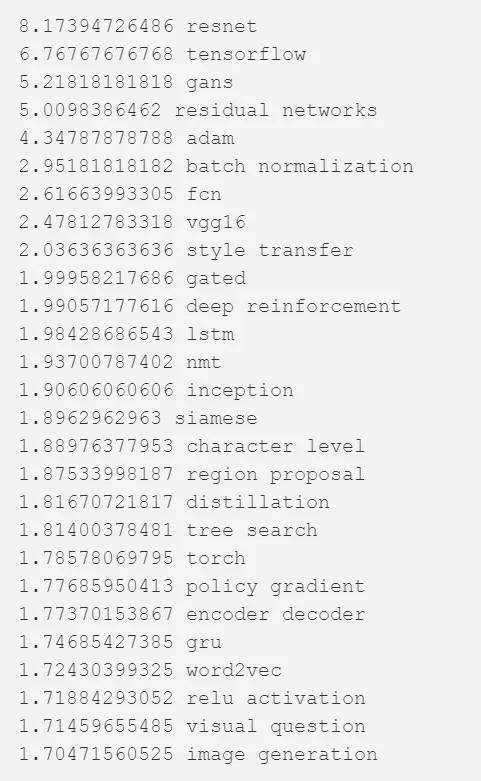

最后一部分是关键词。这里我首先统计了所有一元关键词和二元关键词在论文中的出现情况 ,并对当下和一年之前这些词汇的最大采用率做了对比。这里我作为基准采用的论文都是一些近两年被引用次数最高的优秀论文。以下是一些排名靠前的关键词:

以 ResNet 举例来说,它的相对热度之所以是 8.17,是因为它在 2016 年 3 月所有论文中的采用比是 1.044%,而到了今年 3 月,它的采用比则增长到了 8.53%,用两个百分比相除,就得到了 8.17。

从以上图表可以看出,在过去一年中最火热的机器学习创新技术包括:ResNets、GAN、Adam 和 BatchNorm。在研究方向上热词包括:风格转换(style transfer)、深度强化学习(deep RL)、神经网络翻译以及图像生成等。最后,在模型方面可以看到:全卷积网络(FCN)、 LSTMs/GRUs、Siamese Nets 以及 Encoder decoder nets 等热词。

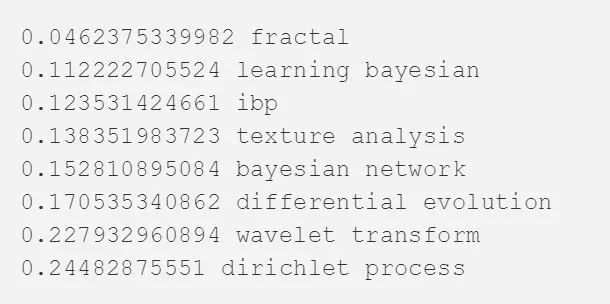

与之相反,哪些关键词在过去一年中出现了下滑,变成了最冷门的关键词?我整理了以下排名:

可以看到,fractal(分形) 和 bayesian(贝叶斯)相关的内容在近一年的时间中热度衰减严重。

总结

话说,看完了所有的分析结果,你不赶紧写一篇基于全卷积神经网络、BatchNorm、ResNet 和 GAN 技术,通过 Adam 算法优化,并应用于风格转换的论文么 :)

来源:medium,雷锋网编译