昨天著名相机评测机构DxOMark放出了华为新旗舰P10的相机评测成绩,最后华为P10的得分定格在87分,这一成绩成绩与Moto Z Force Droid,三星Galaxy S6 Edge Plus,索尼Xperia XZ和索尼Xperia Z5一起并列第三,战胜了iPhone 7等经典机型。

但是我们今天这篇文章的重点并不在华为P10的拍照表现上,DxOMark才是重点,和之前的每次评测成绩一样,DxOMark的打分又一次遭到了网友们的口诛笔伐,很多人认为DxOMark的评测已经不再有公信力,拍照表现并不好的索尼凭什么能够霸榜?华为P10和iPhone 7等机型凭什么不应该排在前几?甚至DxOMark收钱的说法也冒了出来,一时间口水满天飞。

那么DxOMark究竟是怎么做评测的?会不会收厂商的好处费?评测中那些和我们平时的认知相去甚远的成绩究竟是如何得出来的?

DxOMark成立于2003年,一直以来都致力于专业相机和镜头评测,但是近年来也做起了手机拍照的评测。在他们的网站上我们就能看到他们对自己的定义:Objective、Independent、Comprehensive,也就是客观、独立和全面的意思,那么为什么DxOMark还会出现那么多“争议判罚”呢?这就得说说他们“死板”的测评方式了。

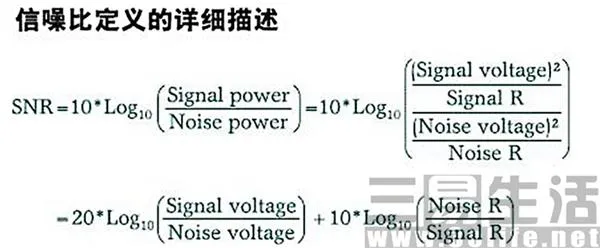

为了达到最精确的测评数据,DxOMark的实验室涂满了哑光材料,温度控制在21-25度,湿度在30-70%之间,现场光源甚至都使用光谱设备进行过色温较正,以严格控制整个测试环境。而他们并不会用肉眼进行横向纵向比较,而是用专业的器材读取出RAW格式照片文件的各项数据,然后根据相关的公式来计算出某个方面的得分,看看下面这张信噪比的计算公式,是不是傻眼了?

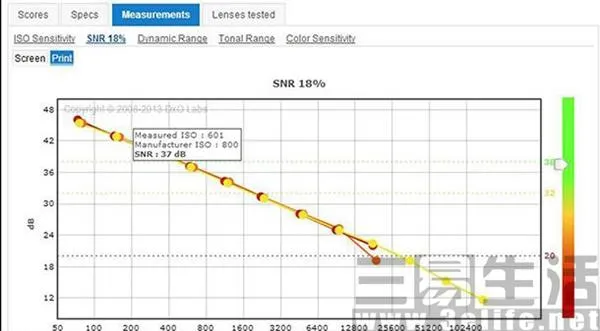

而正是因为DxOMark这种只看数据不看实际表现的测试方法,使得实际观感可能和测试结果会有一定的出入,比如相机的测试标准中就有一项类似的“缺点”:DxOMark在感光度测试中是按Print分(压缩到一定尺寸后的得分)来评分的,而这种算法对于高像素的机型更有优势!而除了Print分之外,其实还有Screen分等测试方法。

右上角有Screen和Print选项

而从这一点我们是否也能推断出,同样的倾向性会不会出现在手机上呢?会不会DxOMark的算法就是对索尼的手机有倾向呢?还有在Artifacts这一项画质劣化问题的测试上,很多老机型的Artifacts的得分远胜新机,让我们不得不怀疑,画质这种玄学问题,用数据真的能完全代替眼睛的观察么?

并且很多手机无法输出RAW,每张样张都是镜头、CMOS、ISP、算法的共同影响产物,后期还有HDR、动态范围改善、降噪、多帧合成甚至是调色等一系列改动。在这种情况下DxOMark依然用具体打分的方法去测试,看似客观,但其实是最主观的做法,DxOMark无法给出手机测试的具体标准、参考文档和原始测试数据就是最好的证明。

在这一点上就凸现出DxOMark作为一家相机评测机构的优势了,专业摄影师只看RAW不看JPG,拍照过程中很少有人会去使用机内滤镜、多帧合成等功能,因为只有RAW文件好,才能给他们的后期调整带来更多发挥的空间。小编觉得可能正是因为以前在测试内容上过多地迎合了专业摄影师需求,才使得DxOMark在手机测试上水土不服吧!

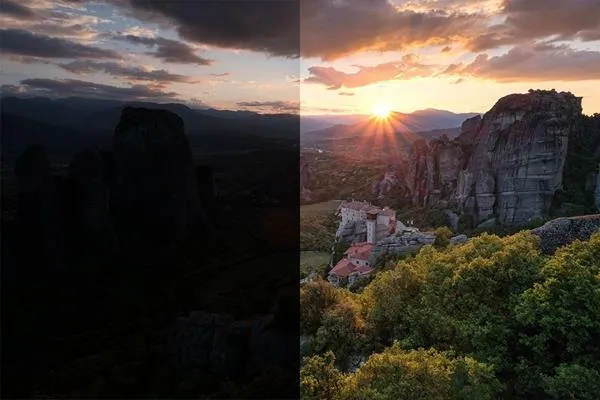

RAW对于后期的重要意义

最后,DxOMark测试过程中视频拍摄也有比较重的权重,视频好的手机得分都偏高。对焦测试、防抖测试也充满疑点,比如在对焦的测试中,有相位对焦的三星S5对焦分数却远不如S4。并且在我们普遍使用自动模式拍照的时候,DxOMark却用使用全手动模式测试,你说这不是为索尼开的小灶?

所以如果要给DxOMark的评分做一个定义的话,从绝对画质上来说,DxOMark的得分虽然有说不清道不明的倾向性,但是依然有着非常强的参考意义,某些画面还真就只有第一名拍得好,第二名就真不行,有的照片100%放大还真就只有那几部手机看得清。

但是对于我们平时的使用过程中,自己对样片进行横向、纵向对比,亲自上手去试用这部手机的拍照体验之后,才能选出最适合我们的手机,有时候真的不能轻易把高得分和高质量划等号,就像我们读书时说的:考试成绩最好的人不一定就是全班最优秀的那个人。