人工智能的崛起导致计算机算法泛滥

凤凰科技讯 北京时间1月29日消息,据英国《卫报》网络版今日报道,专家表示,人工智能会做出严重影响人们正常生活的决定,因此应该建立一个第三方机构,确保人工智能使用的透明度和公平性。

人工智能的快速崛起

人工智能的崛起已经导致计算机算法的数量出现爆发式增长,如今已被银行、警察局以及其他机构所广泛使用,但这些算法可以做出一些严重影响人们正常生活的决定。然而,由于科技公司向来对其算法的工作机制讳莫如深——避免其他公司抄袭——他们极少披露有关人工智能如何做出某些决定的详细信息。

伦敦阿伦·图灵研究中心(Alan Turing Institute)和牛津大学的一个研究小组在最新报告中呼吁创建一个值得信赖的第三方机构,可以对人们认为他们受到歧视的人工智能决定进行调查。这个研究小组的成员包括桑德拉·沃奇特(Sandra Wachter)、布伦特·米特尔斯塔德(Brent Mittelstadt)以及卢西亚·诺弗洛里蒂(Luciano Floridi)。

沃奇特说:“我们希望看到的结果是,一个值得信赖的第三方机构或监管部门,有权对算法进行调查和审计,以确定算法是否真的透明和公正。”实际上,这并不是什么新挑战。早在20世纪80年代,伦敦的圣乔治医学院就曾动用计算机算法对学生申请进行筛选,但这种算法却被发现存在歧视女性和非欧国家人士的现象。

最近,美国航空公司的一位资深驾驶员称,由于计算机算法将他与一位爱尔兰共和军领导人混淆,使得他先后80次在机场遭到拘禁。还有许多人抱怨说,由于人工智能的失误,他们丢了工作,驾驶执照被吊销,选举登记出现错误等等。根据现行法律,因人工智能失误而遭受损失的人可以提出挑战,但最新报告却发现这些法律并不能给人们带来有效保护。

根据英国的《数据保护法案》(Data Protection Act)规定,人们有权对人工智能做出的决定进行挑战。但与其他国家的企业一样,英国的企业无需公布他们认为属于商业机密的信息。在实践中,这意味着企业不必对人工智能的某个决定做出全面解释,只要描述计算机算法的具体工作机制就行了。例如,如果一个人申请信用卡被拒绝,他可能会被告知,算法充分考虑了他的信用记录、年龄和邮政编码,但此人仍然不清楚申请被拒的原因。

提高算法决策过程的透明度

2018年,欧盟成员国以及英国将施行一项新法规,对挑战人工智能决定的细则做出解释。《一般数据保护条例》(以下简称“GDPR”)草案以法律形式诠释了所谓的“解释权”。但最新报告作者认为,在去年获批的最终版本并未在法律上对这种权利做出任何保证。

米特尔斯塔德说:“有观点认为GDPR将在人工智能方面带来问责和透明度,但这一点根本没有得到保证。这一切都取决于英国乃至欧洲法院将来如何对其做出解释。”新法规最值得称道的一点是,“知情权”将强制企业披露算法的作用,在做出决定时提取的数据类型,以及其他基本信息。三位研究人员在报告中建议对这一法规做出修改,让“解释权”具有法律约束力。

诺弗洛里蒂说:“我们对于计算机算法过于依赖,以至于放弃了质疑其决定的权利。应该对GDPR做出改进,确保这种权利得到全面且明确的支持。”在实施这项研究的过程中,三位作者评审了奥地利和德国的一些法律案件,这两个欧洲国家在算法决策上的法规更为严厉。在许多案件中,他们发现法庭只是要求企业公布有关算法如何做出决定的最一般的信息。

沃奇特说:“他们不需要披露算法本身的任何细节,以及如何做出单个决定或者是如何基于数据做出决定的任何细节。”她指出,值得信赖的第三方机构可以消除企业对商业机密外泄的担忧,同时还能让当事人对结果感到满意。“如果算法可以真的影响人们的生活,我们就需要某种监督,以充分了解算法做出决定的过程,”她说。

然而,即便是建立了第三方人工智能监管机构,如何对算法的失误进行管理,可能仍然是一个难题。米特尔斯塔德说:“如何赋予监管机构合适的执法权,目前仍然不太明确,因为我们正在讨论的系统非常复杂,难以预测,还随时间发生变化,而且还很难懂,即便是对开发算法的团队来说。”他补充说,强制企业解释人工智能决策过程,可能会引发抗议,因为一些现代的人工智能方法“基本上都像谜一样”,比如深度学习。

当前面临的紧迫任务

西英格兰大学机器人科学教授艾伦·温菲尔德(Alan Winfield)目前正在牵头实施一个制订人工智能行业标准的项目,目的是让人工智能变得更透明、行为上更负责任。“对人工智能实施监管是一个非常好的提议”,他说,“这并不是一个未来的问题,而是现在就面临的问题。”

不过,温菲尔德也认为,科技公司可能很难说清楚人工智能的决策过程。算法、尤其是基于深度学习做出的算法,含义非常模糊,解释清楚它们是如何决策的,是一项根本无法完成的任务。温菲尔德说:“我认为,谷歌DeepMind之类的项目应该发明一套可以自主解释的深度学习系统。做到这一点可能很难,但幸运的是,有一些才华横溢的人正在开发此类系统。”

美国马里兰大学计算机科学家迪克·迪亚克帕罗斯(Nick Diakopoulos)表示,算法的决定必须根据它们的具体行为做出不同的解释。例如,一旦自动驾驶汽车发生车祸,算法向调查人员说明如何做出的决定,就完全行得通,就像是飞机失事以后,调查人员通过“黑匣子”来寻找答案一样。算法在法庭上帮法官断案的时候,对法官、被告以及清楚人工智能决策过程的法律团队来说,这同样行得通。

迪亚克帕罗斯说:“我认为应该建立一个监管部门,他们有权强制企业必须对导致失误或系统崩溃的人工智能决定做出说明。”

华盛顿特区学校老师萨拉·韦索基(Sarah Wysocki)曾受到学生家长和校长的广泛好评。但是,当华盛顿特区在2009年推出一种算法,用以评估老师绩效表现时,韦索基和另外205名教师得分很低,最终被解雇。事后证明,这种算法的决定是基于少数学生的成绩做出的,部分老师还引导学生弄虚作假,故意让算法犯错误。校方也无法解释好老师被解雇的原因。

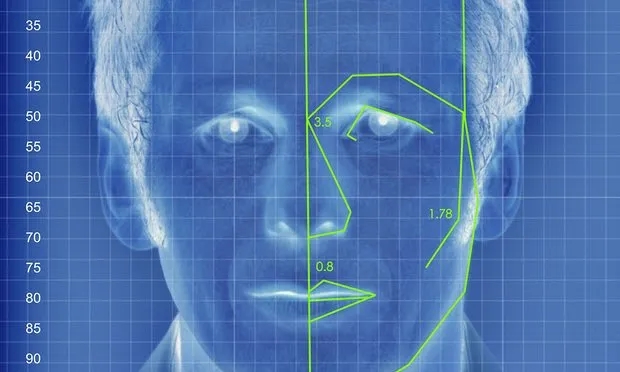

去年,选美比赛组织方曾将算法作为一场国际选美比赛的“评委”。他们原以为算法可以做出比人类更客观的决定,根据面部对称性、脸上皱纹多少及其他手段选出获胜者。但是,在真正的比赛中,这套系统却歧视黑皮肤的女性,严重偏向白人女性。

AI失误例子不胜枚举

马萨诸塞州东部城镇纳蒂克居民约翰·加斯(John Gass)由于反恐面部识别系统将他与另一名司机搞混,导致驾照被吊销。加斯花了十天时间才最终说服政府部门相信面部识别系统出错。

微软曾开发了聊天机器人Tay,用于与Twitter上面的“千禧一代”进行聊天互动。根据设计,Tay可以通过模仿说话者的语言来学会模仿他人。但在上线24小时后,Tay就失去控制,开始发表种族主义言论,例如“希特勒没有做错事”。

在洛杉矶,有一套自动系统本来是帮助爸爸们追踪孩子医保付费情况的,但却错误锁定了数百名无辜男子,他们必须偿还这笔钱,否则只能自证清白。一个名叫沃尔特·沃尔默(Walter Vollmer)的男子就收到了一张20多万美元的账单,他的妻子以为丈夫在外面有外遇,因此选择了自杀。

每个星期,有超过1000人被机场的人工智能系统错误认定为恐怖分子。由于名字与爱尔兰共和军的一名领导人一样,美国航空公司的一名驾驶员在一年间先后80次遭到拘捕。

去年,一位22岁的亚洲籍DJ在申请新西兰护照时遭拒,原因是一套处理其照片的系统自行认定他的双眼都闭上了。不过,这位DJ对此倒并不在意,他在接受路透社采访时说:“它是没有真情实感的机器人。我最终还是拿到了护照。”(编译/清辰)